Enzyklopädie der Informatik. II. Theoretische Grundlagen der Informatik. Annäherung unterschiedlicher Auftrittswahrscheinlichkeiten von Zeichen im Text

Im englischsprachigen Raum wird der Begriff Informatik verwendet – Computer Science.

Die theoretische Grundlage der Informatik ist eine Gruppe von Grundlagenwissenschaften wie: Informationstheorie, Theorie der Algorithmen, mathematische Logik, Theorie der formalen Sprachen und Grammatiken, kombinatorische Analyse usw. Darüber hinaus umfasst die Informatik Bereiche wie Computerarchitektur, Betriebssysteme, Datenbanktheorie, Programmiertechnologie und viele andere. Wichtig bei der Definition der Informatik als Wissenschaft ist, dass sie einerseits Geräte und Funktionsprinzipien von Mitteln untersucht. Informatik, und andererseits die Systematisierung von Techniken und Methoden der Arbeit mit Programmen, die diese Technik steuern.

Informationstechnologie ist eine Reihe von spezifischen Hardware- und Software-Tools, die verwendet werden, um eine Vielzahl von Informationsverarbeitungsvorgängen in allen Bereichen unseres Lebens und unserer Aktivitäten durchzuführen. Informationstechnologie wird manchmal als Computertechnologie oder angewandte Informatik bezeichnet.

Informationen analog und digital.

Der Begriff „Informationen“ stammt aus dem lateinischen informatio, – Erklärung, Darstellung, Bewusstsein.

Informationen können auf unterschiedliche Weise klassifiziert werden, und verschiedene Wissenschaften tun dies auf unterschiedliche Weise. Unterscheide zum Beispiel in der Philosophie zwischen objektiven und subjektiven Informationen. Objektive Informationen spiegeln die Phänomene der Natur und der menschlichen Gesellschaft wider. Subjektive Informationen werden von Menschen geschaffen und spiegeln ihre Sicht auf objektive Phänomene wider.

In der Informatik werden analoge Informationen und digitale Informationen getrennt betrachtet. Das ist wichtig, denn der Mensch ist es dank seiner Sinne gewohnt, mit analogen Informationen umzugehen, während die Computertechnik dagegen hauptsächlich mit digitalen Informationen arbeitet.

Eine Person nimmt Informationen durch die Sinne wahr. Licht, Ton, Wärme sind Energiesignale, und Geschmack und Geruch sind das Ergebnis der Einwirkung chemischer Verbindungen, die ebenfalls auf der Energienatur beruhen. Eine Person erfährt kontinuierlich Energieeinwirkungen und trifft möglicherweise nie zweimal auf dieselbe Kombination. Es gibt keine zwei identischen grünen Blätter an einem Baum und zwei absolut identische Geräusche - das sind analoge Informationen. Wenn verschiedene Farben mit Zahlen versehen sind, und verschiedene Geräusche- Notizen, dann können analoge Informationen in digitale umgewandelt werden.

Musik, wenn sie gehört wird, trägt analoge Informationen, aber wenn sie notiert wird, wird sie digital.

Der Unterschied zwischen analogen Informationen und digitalen Informationen besteht zunächst darin, dass analoge Informationen kontinuierlich sind, während digitale Informationen diskret sind.

Zu den digitalen Geräten gehören Personal Computer – sie arbeiten mit Informationen, die in digitaler Form präsentiert werden, und Musikabspielgeräte von Laser-CDs sind ebenfalls digital.

Informationskodierung.

Das Kodieren von Informationen ist der Prozess der Bildung eines Bestimmten Übermittlung von Informationen.

Im engeren Sinne wird der Begriff "Codierung" oft als Übergang von einer Form der Informationsdarstellung zu einer anderen, bequemer zu speichernden, zu übertragenden oder zu verarbeitenden Form verstanden.

Ein Computer kann nur Informationen verarbeiten, die in numerischer Form dargestellt werden. Alle anderen Informationen (Töne, Bilder, Instrumentenanzeigen usw.) müssen für die Verarbeitung auf einem Computer in numerische Form umgewandelt werden. Um beispielsweise musikalischen Klang zu quantifizieren, kann man die Schallintensität bei bestimmten Frequenzen in kurzen Intervallen messen und die Ergebnisse jeder Messung in numerischer Form darstellen. Mit Hilfe von Computerprogrammen ist es möglich, die empfangenen Informationen umzuwandeln, beispielsweise Töne aus verschiedenen Quellen übereinander zu „überlagern“.

Ebenso können Textinformationen auf einem Computer verarbeitet werden. Bei der Eingabe in einen Computer wird jeder Buchstabe mit einer bestimmten Zahl codiert, und bei der Ausgabe an externe Geräte (Bildschirm oder Druck) werden anhand dieser Zahlen Bilder von Buchstaben für die menschliche Wahrnehmung aufgebaut. Die Entsprechung zwischen einer Menge von Buchstaben und Zahlen wird als Zeichenkodierung bezeichnet.

In der Regel werden alle Zahlen im Computer mit Nullen und Einsen dargestellt (und nicht mit zehn Ziffern, wie es bei Menschen üblich ist). Mit anderen Worten, Computer arbeiten normalerweise binär Zahlensystem, da in diesem Fall die Geräte zu ihrer Verarbeitung viel einfacher sind.

Maßeinheiten für Informationen. Bisschen. Byte.

Ein Bit ist die kleinste Einheit der Informationsdarstellung. Byte - die kleinste Einheit der Informationsverarbeitung und -übertragung .

Bei der Lösung verschiedener Probleme verwendet eine Person Informationen über die Welt um uns herum. Oft hört man, dass eine Nachricht wenig Informationen enthält oder umgekehrt erschöpfende Informationen enthält, während verschiedene Personen, die dieselbe Nachricht erhalten (z. B. nach dem Lesen eines Artikels in einer Zeitung), die darin enthaltene Informationsmenge unterschiedlich einschätzen. Dies bedeutet, dass das Wissen der Menschen über diese Ereignisse (Phänomene) vor dem Empfang der Nachricht unterschiedlich war. Die Menge an Informationen in einer Nachricht hängt also davon ab, wie neu die Nachricht für den Empfänger ist. Wenn durch den Erhalt einer Nachricht vollständige Klarheit über ein bestimmtes Problem erreicht wird (d. h. die Unsicherheit verschwindet), sagen sie, dass erschöpfende Informationen erhalten wurden. Dies bedeutet, dass keine zusätzlichen Informationen zu diesem Thema erforderlich sind. Wenn hingegen nach Erhalt der Nachricht die Unsicherheit unverändert blieb (die gemeldeten Informationen waren entweder bereits bekannt oder nicht relevant), wurden keine Informationen erhalten (Nullinformationen).

Eine Münze zu werfen und ihr beim Fallen zuzusehen, liefert bestimmte Informationen. Beide Seiten der Medaille sind "gleich", also kommen beide Seiten mit gleicher Wahrscheinlichkeit zum Vorschein. In solchen Fällen trägt das Ereignis Informationen in 1 Bit. Wenn wir zwei Bälle unterschiedlicher Farbe in eine Tasche stecken, erhalten wir durch blindes Zeichnen eines Balls auch Informationen über die Farbe des Balls in 1 Bit.

Die Maßeinheit von Informationen wird als Bit (Bit) bezeichnet - eine Abkürzung für die englischen Wörter binäre Ziffer, was bedeutet eine binärziffer.

In der Computertechnik entspricht ein Bit dem physikalischen Zustand des Informationsträgers: magnetisiert – nicht magnetisiert, da ist ein Loch – da ist kein Loch. In diesem Fall wird ein Zustand normalerweise mit der Zahl 0 und der andere mit der Zahl 1 bezeichnet. Wenn Sie sich für eine der beiden möglichen Optionen entscheiden, können Sie auch zwischen logischer Wahrheit und Falschheit unterscheiden. Eine Folge von Bits kann Text, Bild, Ton oder andere Informationen kodieren. Diese Methode der Darstellung von Informationen wird als Binärcodierung bezeichnet. (binäre Kodierung) .

In der Informatik wird häufig eine Größe namens Byte verwendet, die 8 Bit entspricht. Und wenn Sie mit dem Bit eine Option aus zwei möglichen auswählen können, ist das Byte jeweils 1 von 256 (2 8). Zusammen mit Bytes werden größere Einheiten verwendet, um die Informationsmenge zu messen:

1 KB (ein Kilobyte) = 2\up1210 Bytes = 1024 Bytes;

1 MB (ein Megabyte) = 2\up1210 KB = 1024 KB;

1 GB (ein Gigabyte) = 2\up1210 MB = 1024 MB.

Ein Buch enthält beispielsweise 100 Seiten; 35 Zeilen pro Seite, 50 Zeichen pro Zeile. Der Informationsumfang des Buches errechnet sich wie folgt:

Die Seite enthält 35 × 50 = 1750 Bytes an Informationen. Der Umfang aller Informationen im Buch (in verschiedenen Einheiten):

1750 × 100 = 175.000 Byte.

175.000 / 1024 = 170,8984 KB.

170,8984 / 1024 = 0,166893 MB.

Datei. Dateiformate.

Eine Datei ist die kleinste Informationsspeichereinheit, die eine Folge von Bytes enthält und einen eindeutigen Namen hat.

Der Hauptzweck von Dateien besteht darin, Informationen zu speichern. Sie dienen auch dazu, Daten von Programm zu Programm und von System zu System zu übertragen. Mit anderen Worten, eine Datei ist ein Aufbewahrungsort für stabile und mobile Daten. Aber eine Datei ist mehr als nur ein Datenspeicher. Die Datei hat normalerweise Name, Attribute, Änderungszeit und Erstellungszeit.

Eine Dateistruktur ist ein System zum Speichern von Dateien auf einem Speichergerät, beispielsweise einer Festplatte. Dateien sind in Verzeichnissen organisiert (manchmal auch als Verzeichnisse oder Ordner bezeichnet). Jedes Verzeichnis kann eine beliebige Anzahl von Unterverzeichnissen enthalten, von denen jedes Dateien und andere Verzeichnisse speichern kann.

Die Art und Weise, wie Daten in Bytes organisiert sind, wird als Dateiformat bezeichnet. .

Um eine Datei wie eine Tabellenkalkulation zu lesen, müssen Sie wissen, wie die Bytes die Zahlen (Formeln, Text) in jeder Zelle darstellen; um die Datei zu lesen Texteditor müssen Sie wissen, welche Bytes Zeichen darstellen und welche Schriftarten oder Felder sowie andere Informationen.

Programme können Daten auf eine vom Programmierer gewählte Weise in einer Datei speichern. Es wird jedoch oft erwartet, dass die Dateien von verschiedenen Programmen verwendet werden, daher unterstützen viele Anwendungsprogramme einige der gebräuchlicheren Formate, sodass andere Programme die Daten in der Datei verstehen können. Softwareunternehmen (die wollen, dass ihre Programme zu "Standards" werden) veröffentlichen häufig Informationen über die von ihnen erstellten Formate, damit sie in anderen Anwendungen verwendet werden können.

Alle Dateien können bedingt in zwei Teile geteilt werden - Text und Binär.

Textdateien sind die häufigste Art von Daten in der Computerwelt. Am häufigsten wird ein Byte zugewiesen, um jedes Zeichen zu speichern, und Textdateien werden unter Verwendung spezieller Tabellen codiert, in denen jedes Zeichen einer bestimmten Zahl entspricht, die 255 nicht überschreitet. Eine Datei zum Codieren, die nur 127 erste Zahlen verwendet, wird aufgerufen ASCII- Datei (kurz für American Standard Code for Information Intercange - Amerikanischer Standardcode für Informationsaustausch), aber eine solche Datei darf nur lateinische (einschließlich russische) Buchstaben enthalten. Die meisten nationalen Alphabete können mit einer Acht-Bit-Tabelle codiert werden. Für die russische Sprache sind derzeit drei Kodierungen am beliebtesten: Koi8-R, Windows-1251 und die sogenannte alternative (alt) Kodierung.

Sprachen wie Chinesisch enthalten deutlich mehr als 256 Zeichen, daher werden mehrere Bytes verwendet, um jedes Zeichen zu codieren. Um Platz zu sparen, wird oft folgender Trick angewendet: Manche Zeichen werden mit einem Byte kodiert, andere mit zwei oder mehr Bytes. Ein Versuch, diesen Ansatz zu verallgemeinern, ist der Unicode-Standard, der zur Codierung von Zeichen einen Zahlenbereich von 0 bis 65.536 verwendet, der es ermöglicht, die Zeichen einer Sprache aus allen Ecken der Welt numerisch darzustellen.

Aber reine Textdateien werden immer seltener. Dokumente enthalten oft Bilder und Diagramme, und es werden verschiedene Schriftarten verwendet. Als Ergebnis erscheinen Formate, die verschiedene Kombinationen von Text-, Grafik- und anderen Datenformen sind.

Binärdateien sind im Gegensatz zu Textdateien nicht so einfach anzuzeigen und enthalten normalerweise keine vertrauten Wörter - nur viele obskure Zeichen. Diese Dateien sind nicht dazu bestimmt, von Menschen direkt gelesen zu werden. Beispiele für Binärdateien sind ausführbare Programme und Grafikdateien.

Beispiele für die binäre Codierung von Informationen.

Unter der Vielzahl von Informationen, die auf einem Computer verarbeitet werden, besteht ein wesentlicher Teil aus numerischen, textuellen, grafischen und Audioinformationen. Machen wir uns mit einigen Möglichkeiten vertraut, diese Arten von Informationen in einem Computer zu codieren.

Zahlenkodierung.

Es gibt zwei Hauptformate zur Darstellung von Zahlen im Computerspeicher. Einer von ihnen wird verwendet, um Ganzzahlen zu codieren, der zweite (die sogenannte Fließkommadarstellung einer Zahl) wird verwendet, um eine bestimmte Teilmenge reeller Zahlen anzugeben.

Der Satz von ganzen Zahlen, die im Computerspeicher dargestellt werden können, ist begrenzt. Der Wertebereich hängt von der Größe des Speicherbereichs ab, der zum Speichern der Zahlen verwendet wird. IN k-Bit-Zelle kann 2 speichern k verschiedene Werte von ganzen Zahlen .

Um die interne Darstellung einer positiven Ganzzahl zu erhalten n darin gespeichert k-Bit-Maschinenwort, Sie benötigen:

1) übersetze die Zahl N in das binäre Zahlensystem;

2) das erhaltene Ergebnis wird links mit unbedeutenden Nullen bis zu k Stellen ergänzt.

Um beispielsweise die interne Darstellung der Ganzzahl 1607 in einer 2-Byte-Zelle zu erhalten, wird die Zahl in eine Binärzahl umgewandelt: 1607 10 = 11001000111 2 . Die interne Darstellung dieser Nummer in der Zelle ist: 0000 0110 0100 0111.

Um die interne Darstellung einer negativen Ganzzahl (–N) zu schreiben, benötigen Sie:

1) Holen Sie sich die interne Darstellung einer positiven Zahl n;

2) Holen Sie sich den Rückgabecode dieser Nummer, indem Sie 0 durch 1 und 1 durch 0 ersetzen;

3) Addiere 1 zur empfangenen Zahl.

Die interne Darstellung einer negativen ganzen Zahl ist -1607. Unter Verwendung des Ergebnisses des vorherigen Beispiels wird die interne Darstellung der positiven Zahl 1607 geschrieben: 0000 0110 0100 0111. Der umgekehrte Code wird durch Invertieren erhalten: 1111 1001 1011 1000. Eins wird hinzugefügt: 1111 1001 1011 1001 - das ist die interne binäre Darstellung der Zahl -1607.

Das Fließkommaformat verwendet eine reelle Zahlendarstellung R als Produkt der Mantisse m nach dem Zahlensystem n bis zu einem gewissen Grad P, die als Reihenfolge bezeichnet wird: R=m * np.

Die Darstellung einer Zahl in Fließkommaform ist mehrdeutig. Beispielsweise sind die folgenden Gleichheiten wahr:

12,345 \u003d 0,0012345 × 10 4 \u003d 1234,5 × 10 -2 \u003d 0,12345 × 10 2

Am häufigsten verwenden Computer eine normalisierte Darstellung einer Zahl in Fließkommaform. Die Mantisse in dieser Darstellung muss die Bedingung erfüllen:

0,1 p J m P . Mit anderen Worten, die Mantisse ist kleiner als 1 und die erste signifikante Ziffer ist nicht null ( P ist die Basis des Zahlensystems).

Im Computerspeicher wird die Mantisse als Ganzzahl dargestellt, die nur signifikante Ziffern enthält (0-Ganzzahlen und ein Komma werden nicht gespeichert), sodass für die Zahl 12.345 die Zahl 12.345 in der Speicherzelle gespeichert wird, die der Speicherung der Mantisse zugeordnet ist Stellen Sie die ursprüngliche Nummer eindeutig wieder her, es bleibt nur die Reihenfolge zu speichern, in diesem Beispiel ist die 2.

Textentschlüsselung.

Der Satz von Zeichen, der zum Schreiben von Text verwendet wird, wird als Alphabet bezeichnet. Die Anzahl der Zeichen eines Alphabets wird als Kardinalität bezeichnet.

Um Textinformationen in einem Computer darzustellen, wird am häufigsten ein Alphabet mit einer Kapazität von 256 Zeichen verwendet. Ein Zeichen aus einem solchen Alphabet enthält 8 Bits an Informationen, da 2 8 \u003d 256. Aber 8 Bits bilden ein Byte, daher belegt der Binärcode jedes Zeichens 1 Byte Computerspeicher.

Alle Zeichen eines solchen Alphabets sind von 0 bis 255 nummeriert, und jede Zahl entspricht einem 8-Bit-Binärcode von 00000000 bis 11111111. Dieser Code ist die Ordnungszahl des Zeichens im binären Zahlensystem.

Für unterschiedliche Arten von Computern und Betriebssystemen werden unterschiedliche Codierungstabellen verwendet, die sich in der Reihenfolge unterscheiden, in der alphabetische Zeichen in der Codierungstabelle platziert werden. Die bereits erwähnte ASCII-Kodierungstabelle ist der internationale Standard auf Personal Computern.

Das Prinzip der sequentiellen Alphabetcodierung besteht darin, dass in der ASCII-Codetabelle lateinische Buchstaben (Groß- und Kleinbuchstaben) in alphabetischer Reihenfolge angeordnet sind. Die Anordnung der Zahlen ist ebenfalls in aufsteigender Reihenfolge der Werte geordnet.

Nur die ersten 128 Zeichen sind in dieser Tabelle Standard, also Zeichen mit Zahlen von Null (Binärcode 00000000) bis 127 (01111111). Dazu gehören Buchstaben des lateinischen Alphabets, Zahlen, Satzzeichen, Klammern und einige andere Symbole. Die verbleibenden 128 Codes, beginnend mit 128 (Binärcode 10000000) und endend mit 255 (11111111), werden verwendet, um Buchstaben nationaler Alphabete, pseudografischer und wissenschaftlicher Symbole zu codieren.

Kodierung grafischer Informationen.

Der Videospeicher enthält binäre Informationen über das auf dem Bildschirm angezeigte Bild. Fast alle Bilder, die mit einem Computer erstellt, verarbeitet oder angezeigt werden, können in zwei große Teile unterteilt werden - Raster- und Vektorgrafiken.

Rasterbilder sind ein einschichtiges Raster aus Punkten, die Pixel genannt werden (Pixel, vom englischen Bildelement). Der Pixelcode enthält Informationen über seine Farbe.

Bei einem Schwarz-Weiß-Bild (ohne Halbtöne) kann ein Pixel nur zwei Werte annehmen: weiß und schwarz (leuchtet – leuchtet nicht), und ein Bit Speicher reicht aus, um es zu codieren: 1 – weiß, 0 - Schwarz.

Ein Pixel auf einem Farbdisplay kann verschiedene Farben haben, daher reicht ein Bit pro Pixel nicht aus. Zwei Bits pro Pixel sind erforderlich, um ein 4-Farben-Bild zu codieren, da zwei Bits 4 verschiedene Zustände annehmen können. Beispielsweise kann diese Farbcodierungsoption verwendet werden: 00 - Schwarz, 10 - Grün, 01 - Rot, 11 - Braun.

Auf RGB-Monitoren wird die gesamte Farbvielfalt durch die Kombination der Grundfarben Rot (Rot), Grün (Grün), Blau (Blau) erreicht, aus denen Sie 8 Grundkombinationen erhalten können:

Wenn Sie die Intensität (Helligkeit) des Leuchtens der Grundfarben steuern können, erhöht sich natürlich die Anzahl der verschiedenen Kombinationsmöglichkeiten, die verschiedene Schattierungen erzeugen. Anzahl verschiedener Farben - ZU und die Anzahl der Bits, um sie zu codieren - n sind durch eine einfache Formel miteinander verbunden: 2 n = ZU.

Im Gegensatz zu Rastergrafiken Vektorbild geschichtet. Jedes Element eines Vektorbildes - eine Linie, ein Rechteck, ein Kreis oder ein Textfragment - befindet sich in einer eigenen Ebene, deren Pixel unabhängig von anderen Ebenen festgelegt werden. Jedes Element eines Vektorbildes ist ein Objekt, das mit einer speziellen Sprache beschrieben wird (mathematische Gleichungen von Linien, Bögen, Kreisen usw.) Komplexe Objekte (gestrichelte Linien, verschiedene geometrische Formen) werden als eine Menge elementarer grafischer Objekte dargestellt.

Vektorgrafiken können im Gegensatz zu Rastergrafiken ihre Größe ohne Qualitätsverlust verändern (beim Vergrößern Bitmap Granularität nimmt zu).

Toncodierung.

Wir kennen diesen Klang aus der Physik sind Luftschwingungen. Wenn Sie Ton in ein elektrisches Signal umwandeln (z. B. mit einem Mikrofon), können Sie eine Spannung sehen, die sich im Laufe der Zeit fließend ändert. Für die Computerverarbeitung muss ein solches analoges Signal irgendwie in eine Folge von Binärzahlen umgewandelt werden.

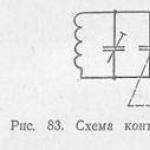

Dies geschieht beispielsweise so - die Spannung wird in regelmäßigen Abständen gemessen und die resultierenden Werte im Speicher des Computers aufgezeichnet. Dieser Vorgang wird als Abtasten (oder Digitalisieren) bezeichnet, und das Gerät, das ihn durchführt, wird als Analog-Digital-Wandler (ADC) bezeichnet.

Um den auf diese Weise codierten Ton wiederzugeben, müssen Sie die Rückwandlung durchführen (dazu wird ein Digital-Analog-Wandler verwendet). - DAC) und dann das resultierende Schrittsignal glätten.

Je höher die Samplingrate und je mehr Bits jedem Sample zugewiesen werden, desto genauer wird der Sound dargestellt, aber auch die Größe der Sounddatei nimmt zu. Daher werden je nach Art des Klangs, den Anforderungen an seine Qualität und der Menge des belegten Speichers einige Kompromisswerte gewählt.

Die beschriebene Methode zum Codieren von Toninformationen ist ziemlich universell. Sie ermöglicht es Ihnen, jeden Ton darzustellen und auf verschiedene Weise zu transformieren. Aber es gibt Zeiten, in denen es vorteilhafter ist, anders zu handeln.

Eine ziemlich kompakte Art, Musik darzustellen, wird seit langem verwendet - die Notenschrift. Es zeigt mit speziellen Symbolen an, wie hoch der Ton ist, auf welchem Instrument und wie zu spielen ist. Tatsächlich kann es als ein Algorithmus für einen Musiker betrachtet werden, der in einer speziellen formalen Sprache geschrieben ist. 1983 entwickelten führende Hersteller von Computern und Musiksynthesizern einen Standard, der ein solches Codesystem definierte. Es heißt MIDI.

Natürlich können Sie mit einem solchen Codierungssystem nicht jeden Ton aufnehmen, es eignet sich nur für Instrumentalmusik. Aber es hat auch unbestreitbare Vorteile: eine äußerst kompakte Aufnahme, Natürlichkeit für einen Musiker (fast jeder MIDI-Editor ermöglicht es Ihnen, mit Musik in Form gewöhnlicher Noten zu arbeiten), ein einfacher Instrumentenwechsel, das Ändern des Tempos und der Tonart der Melodie.

Es gibt andere, reine Computer-Musikaufzeichnungsformate. Darunter ist das MP3-Format, mit dem Sie Musik mit sehr hoher Qualität und Komprimierung codieren können, während statt 18–20 Musikkompositionen etwa 200 auf einer Standard-CD (CDROM) gespeichert werden.Ein Lied belegt etwa 3,5 MB, was ermöglicht es Internetnutzern, Musikkompositionen auszutauschen.

Der Computer ist eine universelle Informationsmaschine.

Einer der Hauptzwecke eines Computers ist die Verarbeitung und Speicherung von Informationen. Mit dem Aufkommen von Computern wurde es möglich, mit zuvor undenkbaren Mengen an Informationen zu arbeiten. Bibliotheken mit wissenschaftlicher und belletristischer Literatur werden in elektronische Form gebracht. Alte Foto- und Filmarchive werden in digitaler Form zu neuem Leben erweckt.

Anna Tschugainowa

Der allgemeine Name „Dokumentation“, der manchmal als Synonym für den Begriff „I.“ dient. 1931 wurde das International Bibliographical Institute von P. Otlet, einem belgischen Anwalt und einer Persönlichkeit des öffentlichen Lebens, gegründet. La Fontaine wurde 1895 in International Documentation Institute umbenannt und 1938 in International Documentation Federation, die weiterhin die wichtigste internationale Organisation ist, die Spezialisten für . sowie Wissenschafts- und Informationsaktivitäten (siehe Dokumentation Internationale Föderation). 1945 veröffentlichte der amerikanische Wissenschaftler und Ingenieur W. Bush The Possible Mechanism of Our Thinking, in dem erstmals die Frage nach der Notwendigkeit einer Mechanisierung des Informationsabrufs auf breiter Ebene gestellt wurde. Internationale Konferenzen über wissenschaftliche Information (London, 1948; Washington, 1958) markierten die ersten Etappen in der Entwicklung von I. Die durchgeführte Untersuchung der Muster der Streuung wissenschaftlicher Veröffentlichungen war von großer Bedeutung. Bradford (Großbritannien, 1948). Bis Mitte der 60er Jahre. 20. Jahrhundert hauptsächlich wurden Prinzipien und Methoden der Informationsbeschaffung und technische Mittel zu ihrer Umsetzung entwickelt. W. Batten (Großbritannien), . Muer und. Taube (USA) legte den Grundstein für die Koordinatenerschließung; . Vicker, . Fosket (Großbritannien), J. Perry, A. Kent , J. Costello, . P.Lun, . Bernier (USA), . C. Garden (Frankreich) entwickelte die Grundlagen der Theorie und Methodik des Informationsabrufs; S. Cleverdon (Großbritannien) untersuchte Methoden zum Vergleich der technischen Leistungsfähigkeit von Informationsbeschaffungssystemen verschiedener Art; R. Shaw (USA) und J. Samin (Frankreich) schufen die ersten Informationsabrufgeräte auf Mikrofilmen und Diamikrokarten, die als Prototypen für viele spezielle Informationsmaschinen dienten; K. Muller und C. Carlson (USA) schlugen neue Methoden der Dokumentenreproduktion vor, die die Grundlage moderner Reprographietechniken bildeten. Die gegenwärtige Phase der Informationsentwicklung (die 1970er Jahre) ist gekennzeichnet durch ein tieferes Verständnis der allgemeinen wissenschaftlichen Bedeutung wissenschaftlicher Informationstätigkeit und der immer breiteren Verwendung elektronischer Computer darin. D. Price (USA) wies in Weiterentwicklung der Ideen von J. Bernal (Großbritannien) auf die Möglichkeit hin, die Entwicklungsprozesse der Wissenschaft mit Indikatoren und Mitteln von I. zu messen; . Garfield (USA) entwickelte und führte neue Methoden des wissenschaftlichen Informationsdienstes ein; G. Menzel und W. Garvey (USA) untersuchten den Informationsbedarf von Wissenschaftlern und Fachleuten, die Bedeutung verschiedener Prozesse der Wissenschaftskommunikation. Die allgemeine Theorie von I. im Ausland wird in den Arbeiten von A. Avramescu (Rumänien), A. Vysotsky und M. Dembovskaya (Polen), I. Koblitz (DDR), A. Merta (Tschechoslowakei), I. Polzovich (Ungarn), . Peach (Deutschland), A. Rees, R. Taylor, J. Shira (USA), R. Fairthorn (Großbritannien) ua In der UdSSR verlief die Entwicklung von Wissenschafts- und Informationsaktivitäten parallel zur Entwicklung der sowjetischen Wissenschaft und der Volkswirtschaft. In den 30er Jahren. 20. Jahrhundert Die Kommission für die Veröffentlichung von Indizes (Indizes) wissenschaftlicher Literatur arbeitete, abstrakte Zeitschriften der Akademie der Wissenschaften der UdSSR in den physikalischen und mathematischen Wissenschaften, der Chemie usw. begannen zu erscheinen (siehe Bibliographie). Besonders intensiv entwickelte sich diese Tätigkeit ab den 50er Jahren. Die Entstehung von I. als eigenständige wissenschaftliche Disziplin geht auf das Ende der 40er, Anfang der 50er Jahre zurück. In der UdSSR wurde Information 1952 institutionalisiert, als das Institut für wissenschaftliche Information der Akademie der Wissenschaften der UdSSR, heute das All-Union Scientific and Technical Institute of Information (VINITI), gegründet wurde. Seit 1959 hat der Ministerrat der UdSSR eine Reihe von Resolutionen angenommen, die auf die Verbesserung und Entwicklung eines einheitlichen landesweiten Systems wissenschaftlicher und technischer Informationen abzielen. Drei unionsweite Konferenzen über die automatisierte Verarbeitung wissenschaftlicher Informationen (1961, 1963 und 1966) waren wichtige Etappen in der Entwicklung der Informationstechnologie in der UdSSR. Von großer Bedeutung für die Entwicklung der Theorie von I. war das internationale Symposium der Mitgliedsländer des Rates für gegenseitige Wirtschaftshilfe und Jugoslawiens über theoretische Probleme der Informatik (Moskau, 1970), und für die Verbesserung der technischen Mittel von I - die internationalen Ausstellungen "Inforga-65" und "Interorgtekhnika-66", die die technischen Mittel der komplexen Mechanisierung und Automatisierung der Prozesse der Verarbeitung, Speicherung, Suche und Verbreitung wissenschaftlicher Informationen demonstrierten. Viele Studien des Russischen I. bildeten die Grundlage für seine weitere Entwicklung: im Bereich der allgemeinen Theorie von I. - die Arbeit von V. A. Uspensky, Yu. A. Shreider; Aufbau von Informationsabrufsystemen - G. E. Vladutsa, D. G. Lakhuti, E. . Skorokhodko, V. P. Cherenina; wissenschaftliche Probleme von I. - G. M. Dobrova, V. V. Nalimova; Dokumentarfilme - G. G. Vorobyova, K. R. Simona,. I. Shamurina; Erstellung von Geräten zum Abrufen von Informationen und anderen technischen Mitteln - . I. Gutenmakher, V. A. Kalmanson, B. M. Rakov u. a. I. gliedert sich in folgende Abschnitte: Theorie von I. (Gegenstand und Methoden, Inhalt, Struktur und Eigenschaften wissenschaftlicher Information), Wissenschaftliche Kommunikation (informelle und formelle Prozesse, wissenschaftliche Informationstätigkeit), Informationsbeschaffung, Verbreitung und Nutzung wissenschaftlicher Informationen, Organisation und Geschichte der wissenschaftlichen Informationstätigkeit. Die wichtigsten theoretischen Aufgaben bestehen darin, die allgemeinen Muster der Erstellung wissenschaftlicher Informationen, ihrer Umwandlung, Weitergabe und Verwendung in verschiedenen Bereichen menschlicher Tätigkeit aufzudecken. I. untersucht und entwickelt keine Kriterien zur Beurteilung der Wahrheit, Neuheit und Nützlichkeit wissenschaftlicher Informationen sowie Methoden zu ihrer logischen Verarbeitung, um neue Informationen zu erhalten. Die angewandten Aufgaben von I. bestehen darin, effektivere Methoden und Mittel zur Umsetzung von Informationsprozessen zu entwickeln, um die optimale Wissenschaftskommunikation sowohl innerhalb der Wissenschaft als auch zwischen Wissenschaft und Wirtschaft zu ermitteln. Für das Studium bestimmter Probleme und die Lösung angewandter Probleme der Informationstechnologie werden separate Methoden verwendet: Kybernetik (bei der Formalisierung der Prozesse der wissenschaftlichen Informationstätigkeit für ihre Automatisierung, beim Bau informationslogischer Maschinen usw.); mathematische Informationstheorie (bei der Untersuchung der allgemeinen Eigenschaften von Informationen, um ihre optimale Codierung, Langzeitspeicherung, Übertragung über eine Entfernung sicherzustellen); mathematische Logik (zur Formalisierung der Prozesse der logischen Inferenz, Entwicklung von Methoden zur Programmierung von Informationsalgorithmen usw.); Semiotik (beim Aufbau von Informationsabrufsystemen, beim Erstellen von Übersetzungsregeln von natürlichen Sprachen in künstliche und umgekehrt, beim Entwickeln von Indexierungsprinzipien, beim Studieren von Textstrukturtransformationen, die ihre Bedeutung nicht ändern usw.); Linguistik (bei der Entwicklung der Prinzipien der automatischen Übersetzung und der Sprachen für den Informationsabruf, der Indexierung und Zusammenfassung, der Methoden der Transkription und Transliteration, der Zusammenstellung von Thesauri, der Straffung der Terminologie); Psychologie (bei der Untersuchung der Denkprozesse bei der Erstellung und Verwendung wissenschaftlicher Informationen, der Art der Informationsbedürfnisse und ihrer Formulierung in Abfragen, bei der Entwicklung effektiver Lesemethoden, maschineller Informationsdienstsysteme, der Gestaltung von Informationsgeräten); Buchwissenschaft, Bibliothekswissenschaft, Bibliographie, Archivwissenschaft (bei der Entwicklung optimaler Formen eines wissenschaftlichen Dokuments, der Verbesserung der formalen Prozesse der wissenschaftlichen Kommunikation, des Systems der Zweitveröffentlichungen); Wissenschaftswissenschaft (bei der Untersuchung der informellen Prozesse der wissenschaftlichen Kommunikation, der Entwicklung der Organisationsprinzipien eines Informationsdienstsystems, der Prognose der Entwicklung der Wissenschaft, der Bewertung ihres Niveaus und Tempos, der Untersuchung verschiedener Kategorien von Verbrauchern wissenschaftlicher Informationen); technische Wissenschaften (zur Bereitstellung technischer Mittel für die Prozesse wissenschaftlicher und informationsbezogener Aktivitäten, deren Mechanisierung und Automatisierung). Einige I. Methoden wiederum finden Anwendung in der Bibliothekswissenschaft und Bibliographie (bei der Erstellung von Katalogen, Verzeichnissen etc.). Wissenschaftliche Informationen spiegeln die objektiven Gesetzmäßigkeiten von Natur, Gesellschaft und Denken adäquat dem aktuellen Stand der Wissenschaft wider und werden in der sozialgeschichtlichen Praxis genutzt. Da die Grundlage des Erkenntnisprozesses die soziale Praxis ist, ist die Quelle wissenschaftlicher Informationen nicht nur die wissenschaftliche Forschung, sondern auch alle Arten von energischen Aktivitäten von Menschen zur Transformation von Natur und Gesellschaft. Wissenschaftliche Informationen werden nach den Bereichen ihrer Aufnahme und Nutzung (biologische, politische, technische, chemische, wirtschaftliche usw.) und nach ihrem Zweck (Massen- und Spezialinformationen usw.) in Typen unterteilt. Hypothesen und Theorien, die sich später als irrig herausstellen, sind wissenschaftliche Informationen für die gesamte Zeit, in der sie systematisch studiert und ihre Bestimmungen in der Praxis überprüft werden. Das Kriterium des Gebrauchs in der sozialgeschichtlichen Praxis ermöglicht es, wissenschaftliche Informationen von bekannten oder überholten Wahrheiten, Science-Fiction-Ideen usw. zu unterscheiden. Die Gesamtheit der Prozesse des Präsentierens, Übermittelns und Empfangens wissenschaftlicher Informationen macht wissenschaftliche Kommunikation aus. An allen Prozessen der Wissenschaftskommunikation sind ausnahmslos Wissenschaftler oder Spezialisten beteiligt. Der Grad ihrer Beteiligung kann unterschiedlich sein und hängt von den Besonderheiten des Prozesses ab. Unterscheiden Sie zwischen „informellen“ und „formellen“ Verfahren. „Informell“ bezieht sich auf jene Prozesse, die hauptsächlich von Wissenschaftlern oder Spezialisten selbst durchgeführt werden: ein direkter Dialog zwischen ihnen über laufende Forschung oder Entwicklung, der Besuch des Labors ihrer Kollegen und wissenschaftlicher und technischer Ausstellungen, das Sprechen mit einem Publikum, der Austausch von Briefen und Nachdrucken Veröffentlichungen, Aufbereitung von Forschungsergebnissen oder Entwicklungen zur Veröffentlichung. Die "formellen" umfassen: Redaktions-, Veröffentlichungs- und Druckprozesse; Vertrieb von wissenschaftlichen Veröffentlichungen, einschließlich Buchhandel, Bibliotheks- und bibliografische Aktivitäten; wissenschaftliche Literaturaustauschprozesse; Archivierung; eigentlich wissenschaftliche und informative Tätigkeit. Alle „formalen“ Prozesse, mit Ausnahme des letzten, sind nicht spezifisch für die Wissenschaftskommunikation und gehören zum Bereich der Massenkommunikation, deren Hauptmedien Print, Radio, Fernsehen usw. sind. Die erhöhte Komplexität der wissenschaftlichen Arbeit und die Notwendigkeit, seine Effizienz zu steigern, führt zu seiner weiteren Aufteilung, die auf verschiedenen Ebenen stattfindet: auf theoretische und experimentelle Forschung, auf wissenschaftliche Forschung, wissenschaftliche Information und wissenschaftliche und organisatorische Aktivitäten. Den Informationsdiensten werden immer komplexere Aufgaben der Auswahl und Aufbereitung wissenschaftlicher Informationen übertragen, die nur unter gleichzeitiger Nutzung der Informationsleistungen sowie der Theorien und Methoden spezifischer Wissenschaftszweige gelöst werden können. Die wissenschaftliche Informationstätigkeit besteht in der Sammlung, Verarbeitung, Speicherung und Suche von in Dokumenten fixierten wissenschaftlichen Informationen sowie in ihrer Bereitstellung für Wissenschaftler und Fachleute, um die Effizienz von Forschung und Entwicklung zu steigern. Diese Tätigkeit wird zunehmend von integrierten Informationssystemen ausgeführt, die auf dem Prinzip einer einmaligen erschöpfenden Bearbeitung jedes wissenschaftlichen Dokuments durch hochqualifizierte Spezialisten beruhen, die Ergebnisse dieser Bearbeitung in einen Maschinenkomplex, bestehend aus einem Computer und einer Fotosatzmaschine, eingeben und wiederverwenden Ergebnisse zur Lösung verschiedener Informationsprobleme: Veröffentlichung von Abstract-Journalen , Bulletins mit Signalinformationen, analytische Überprüfungen, Sammlungen von Übersetzungen, zur Durchführung einer selektiven Verbreitung von Informationen (siehe Informationssprache), Referenz- und Informationsarbeit, Kopieren von Dokumenten und andere Arten von Informationsdiensten. Seit Mitte der 40er Jahre. 20. Jahrhundert die ersten großen Zeitschriften zu I. erscheinen in verschiedenen Ländern: das Journal of Documentation (L., seit 1945); "Tidskrift for Documentation" (Stockh., seit 1945); "American Documentation" (Wash., seit 1950, seit 1970 - "Journal of the American Society for Information Science"); "Nachrichten für Dokumentation" (Fr./M., seit 1950); "Dokumentation" (Lpz., seit 1953, seit 1969 - "Informatik"). Seit Oktober 1961 erscheint in der UdSSR die monatliche Sammlung Wissenschaftliche und Technische Informationen, die seit 1967 in zwei Reihen erschienen ist: Organisation und Methoden der Informationsarbeit und Informationsprozesse und -systeme. Seit 1963 veröffentlicht VINITI zunächst alle 2 Monate und seit 1966 monatlich die Abstract-Zeitschrift "Scientific and Technical Information", die seit 1970 unter dem Namen "Informatics" erscheint. Seit 1967 erscheint dieses Magazin auch in englischer Sprache. Die folgenden Abstract-Zeitschriften zu I. werden im Ausland veröffentlicht: in Großbritannien - "Library and Information Science Abstracts" (L., seit 1969; 1950-68 hieß es "Library Science Abstracts"), in den USA - "Information Science Abstracts" (Phil. , seit 1969; 1966-68 hieß es "Documentation Abstracts"), in Frankreich - "Bulletin signaletique. Information scientifique et technique“ (P., seit 1970). Seit 1964 erscheint die Express-Information "Theorie und Praxis wissenschaftlicher Information" und seit 1965 - Sammlungen von Übersetzungen ausländischer Publikationen zu I. Seit 1969 erscheint in Kiew die Zeitschriftensammlung „Wissenschaft und Informatik“. Die Ausbildung wissenschaftlicher Mitarbeiter in I. erfolgt seit 1959 durch die Graduiertenschule von VINITI, die Ausbildung von Personal für wissenschaftliche und informationstechnische Tätigkeiten - seit 1963 an den Fortbildungskursen für leitende Ingenieure und technisch-naturwissenschaftliche Mitarbeiter (seit 1972 - das Institute for Advanced Studies of Information Workers), die Ausbildung junger Wissenschaftler - zukünftiger Informationskonsumenten - seit 1964 an der Abteilung für wissenschaftliche Information der Staatlichen Universität Moskau. M. V. Lomonosov, Ingenieure für die Mechanisierung und Automatisierung von Informationsprozessen - in einer Reihe von Fachhochschulen und Maschinenbauinstituten. Im Ausland werden Informationswissenschaften an Universitäten und höheren Fachschulen gelehrt. Es besteht die Tendenz, in einer pädagogischen Spezialisierung einen Komplex von Problemen der Informatik und der Computertechnologie zu vereinen. Lit.: Mikhailov A. I., Cherny A. I., Gilyarevsky R. S., Fundamentals of Informatics, 2. Aufl., M., 1968; sie, Informationsprobleme in der modernen Wissenschaft, M., 1972; Theoretische Probleme der Informatik. Sa. Art., M., 1968; Internationales Forum für Informatik. Sa. Art., Bd. 1-2, M., 1969; Bush V., As we may think, Atlantic Monthly, 1945, Juli, p. 101-108; Jährliche Überprüfung der Informationswissenschaft und -technologie, v. 1-7, N.Y.-a. o., 1966-72; Dembowska M., Dokumentation und wissenschaftliche Information, Warschau, 1968. A. I. Mikhailov, A. I. Cherny, R. S. Gilyarevsky.

M.: FIZMATLIT, 2006. - 768 S.

Das enzyklopädische Referenzwörterbuch enthält mehr als 18.000 russische und englische Begriffe, die thematisch in die folgenden Hauptabschnitte systematisiert sind: I. Grundlagen der Informationstechnologie; II. Automatisierung von Informationsprozessen und automatisierten Systemen (AC); III. Technische Unterstützung der AU; IV. AS-Software; V. Multimedia, Hypermedia, virtuelle Realität, maschinelles Sehen; VI. Netzwerktechnologien zur Datenverarbeitung und -übertragung; VII. Computer- und Netzwerk-Slang; VIII. In E-Mails verwendete Piktogramme; IX. Abkürzungen von Wörtern und Ausdrücken, die im Internet verwendet werden.

Die Wörterbucheinträge sind erweiterter Natur und enthalten Referenzdaten zu den Beschreibungsobjekten sowie Links zu primären dokumentarischen Quellen für eine vollständigere Bekanntschaft mit ihnen für interessierte Benutzer.

Die Struktur und der Inhalt des Wörterbuchs ermöglichen es, es für ein systematisches Studium von Materialien zu den für den Leser interessanten thematischen Abschnitten und Unterabschnitten zu verwenden, um eine Vorstudie zu Entscheidungen im Zusammenhang mit der Gestaltung heterogener automatisierter Informations- und Telekommunikationssysteme durchzuführen , sowie die Dokumente auf ihrer Grundlage pädagogisch-methodisch vorzubereiten, zu rezensieren, nachzuschlagen usw.

Das Wörterbuch richtet sich an ein breites Spektrum von Nutzern, deren berufliche Tätigkeiten oder Interessen einen Bezug zu modernen Informationstechnologien haben.

Format: djvu

Größe: 7,1 MB

Herunterladen: yandex.disk

INHALT

Vorwort zur enzyklopädischen Ausgabe des Wörterbuchs ................................... 7

Vorwort zur dritten Auflage des Wörterbuchs, über das Referenzwörterbuch und seinen Autor ... 9

Vom Autor .......................................... ... .... elf

Über die Verwendung des Wörterbuchs .................................. 13

I. Grundlagen der Informationstechnik................................. 15

1.1. Daten, Informationen, Wissen, Logik....................................... 15

1.2. Informationsressourcen, Informationstheorie, Informatik 19

1.3. Datenträger, Dokumente, Dokumentationen, Veröffentlichungen ...................... 22

1.4. Prinzipien der strukturierten Darstellung von Dokumenten und Daten....... 27

1.4.1. Informationselemente und ihre Typen .................................. 27

1.4.2. Datensatz, Datei, Array, Schlüssel .................................... 30

1.4.3. Strukturen, Datenmodelle und verwandte Begriffe 34

1.4.4. Format, Datenfeld und verwandte Begriffe ......................... 45

1.5. Informationstechnologie................................................ 49

1.5.1. Allgemeine Konzepte und Begriffe................................ 49

1.5.2. Handhabung und Verarbeitung von Dokumenten und Daten................................. 52

1.5.3. Eingeben von Dokumenten und Daten in einen Computer ......................... 58

1.5.4. Informationsabruf ^ allgemeine Konzepte und Begriffe ......... 63

1.5.5. Indizierung, Suchbild von Dokumenten und Abfragen 66

1.6. Sicherheit der Informationstechnologie................................ 74

1.6.1. Allgemeine Konzepte und Begriffe................................. 74

1.6.2. Verschlüsseln und Entschlüsseln von Dokumenten und Daten................. 83

1.6.3. Kryptologie und verwandte Konzepte .......................... 87

II. Automatisierung von Informationsprozessen und automatisierten Informationssystemen 93

2.1. Allgemeine Konzepte und Begriffe .................................. 93

2.2. Automatisierung von Informations- und Bibliotheksprozessen................. 95

2.2.1. Begriffe im Zusammenhang mit der Automatisierung................. 95

2.3. Automatisierte Systeme................................. 98

2.3.1. Allgemeine Konzepte und Begriffe................. 98

2.3.2. Funktionsorientierte automatisierte Systeme..... 106

2.4. Sprach- und Informationsunterstützung automatisierter Systeme 117

2.4.1. Sprachliche Unterstützung ^ allgemeine Konzepte und Begriffe ......... 117

2.4.2. Informationsabrufsprachen und AIS-Wörterbücher ...... 119

2.4.3. AIS-Metadaten und -Formate 128

2.4.4. Informationsunterstützung von AIS .................................. 147

2.5. Personal und Benutzer von automatisierten Systemen .................... 153

2.5.1. AIS-Entwickler und -Personal ......................... 153

2.5.2. AIS-Benutzer ................................................... 157

2.5.3. Zertifizierung von Spezialisten für AIS .................................. 159

2.6. Prozesse der Erstellung und des Betriebs automatisierter Systeme .......... 162

2.6.1. Design automatisierter Systeme................................. 162

2.6.2. AIS-Lebenszyklus und Systemintegration................................. 165

III. Technischer Support von automatisierten Systemen .......... 169

3.1. Computer, ihre Typen und allgemeine Klassifizierung 169

3.2. Architektur, Konfiguration, Computerplattform....................... 175

3.3. Personalcomputer (PCs) .................................. 178

3.4. Tragbare PCs und eigenständige digitale Geräte für verschiedene Zwecke ... 185

3.4.1. Arten von Laptops .................................................. 185

3.4.2. Digitale Wiedergabe- und Aufnahmegeräte 188

3.5. Die Systemeinheit und ihre Konstruktionselemente .................... 191

3.5.1. Prozessoren, ihre Typen und verwandte Begriffe....... 192

3.5.2. Computerspeicher ^ Konzepte und Begriffe ......................... 202

3.5.3. Funktionale Geräte des Computerspeichers .................. 208

3.5.4. Adapter, Schnittstellen und verwandte Begriffe................. 216

3.5.5. Boards, Ports, Busse, Slots................................. 224

3.6. Periphere (externe) Computergeräte .................................... 233

3.6.1. Externer Computerspeicher, Laufwerke und verwandte Begriffe ..... 233

3.6.2. CDs und verwandte Begriffe................................. 251

3.6.3. Dateneingabegeräte, Manipulatoren .......................... 260

3.6.4. Ausgabegeräte................................................ 271

3.6.5. Modems, Encoder, Netzteile....................... 286

3.7. PC-Karten .................................................... ......... .. 289

3.8. Mikroelektronische Computerbasis .................................... 294

3.9. Optoelektronische Bauelemente................................ 299

IV. Software für automatisierte Systeme .......... 303

4.1. Algorithmen, Programme, Programmierung....................................... 303

4.1.1. Allgemeine Konzepte und Begriffe 303

4.1.2. Programmiersprachen .................................... 307

4.1.3. Programmierbezogene Begriffe................................. 319

4.2. Allgemeine Software................................ 327

4.2.1. Betriebssysteme ................................... 328

4.2.2. Allgemeine Software-Service-Tools 338

4.3. Anwendungssoftware für automatisierte Systeme....... 339

4.3.1. Allgemeine Konzepte und Begriffe ...................... 339

4.3.2. Anwendungsprogramme .................................... 342

4.3.3. Computerviren und Antivirenprogramme .......................... 346

4.4. Begriffe im Zusammenhang mit dem Betrieb von Softwaretools 350

4.4.1. Einige allgemeine Konzepte und Begriffe ...................... 350

4.4.2. Datensätze archivieren, komprimieren, wiederherstellen ......... 352

4.4.3. Zugang, Adresse und verwandte Begriffe................................. 364

V. Multimedia, Hypermedia, virtuelle Realität, maschinelles Sehen. 372

5.1. Multimediasysteme und verwandte Begriffe. ................. 372

5.2. Mittel zur musikalischen und sprachlichen Begleitung .......... 375

5.2.1. Allgemeine Konzepte und Begriffe................................. 375

5.2.2. Tondateien, ihre Standards und Formate ................................... 380

5.3. Maschinen-(Computer-)Grafik .................................. 389

5.3.1. Allgemeine Konzepte und Begriffe................................ 389

5.3.2. Grafikdateien und ihre Formate................................. 392

5.3.3. Computergraphiktechnologie................................ 400

5.4. Computervideo, digitales Fernsehen und Animation ................................ 408

5.4.1. Allgemeine Konzepte und Begriffe................................. 408

5.4.2. Videotechnik .................................................... 412

5.4.3. Animationstechnologie................................ 416

5.4.4. Digitalfernsehen 420

5.5. Virtuelle Realität, Parallelwelten. ...................... 424

5.6. Maschinelles Sehen................................................ 427

VI. Netzwerktechnologien. Mittel zur Verarbeitung und Übertragung von Informationen 430

6.1. Allgemeine Konzepte und Begriffe ...................... 430

6.2. Lokale Netzwerke................................................ 433

6.3. Verteilte Computernetzwerke................................. 441

6.3.1. Allgemeine Konzepte und Begriffe................................. 441

6.3.2. Intranet................................ 450

6.3.3. ETHERNET ......................... 455

6.4. Globale Datenverarbeitungsnetze, Internet ...................... 471

6.4.1. Allgemeine Konzepte und Begriffe................................. 471

6.4.2. Web-Technologie................................................ 482

6.4.3. Technologien für die Datenübertragung über Internetkanäle....................... 489

6.4.4. Dienste und Service-Tools im Internet................................. 499

6.4.5. Integrierte digitale Netzwerkdienste - ISDN .................................. 518

6.4.6. Mobilfunk und Computertelefonie .................................. 520

6.4.7. Fernmeldeanlagen von Gebäuden .................................. 526

6.4.8. Entwicklung technischer Mittel und Komplexe auf der Grundlage der Nutzung von Telekommunikationstechnologien 532

6.4.9. Themen des Rechtsverkehrs im Internet .................................. 533

6.5. Mittel und Technologien zum Schutz von Computernetzwerken................................. 536

6.6. Grundlegende Standards für Datennetze. ......................... 541

6.6.1. ISO-Normen ................................................ . 541

6.6.2. IEEE-Standards ................................ 543

6.6.3. ITU-T-Standards .................................................. 554

6.6.4. Andere Standards und Protokolle................................. 560

VII. Computer- und Netzwerk-Slang .................................. 565

VIII. E-Mail-Symbole und Emoticon-Symbole....... 592

IX. Abkürzungen von Wörtern und Ausdrücken, die im Internet verwendet werden ...... 594

Referenzen ................................................ 597

Englischer alphabetischer Index................................................. 644

Russischer alphabetischer Index................................................. ... 708

INFORMATION (englische Informatik), die Wissenschaft des Extrahierens von Informationen aus Nachrichten, Erstellen von Informationsressourcen, Programmieren des Verhaltens von Maschinen und anderen Entitäten im Zusammenhang mit der Konstruktion und Verwendung einer Mensch-Maschine-Umgebung zur Lösung von Problemen der Modellierung, des Designs, der Interaktion, des Lernens, usw. Es untersucht die Eigenschaften von Informationen, Methoden, um sie aus Nachrichten zu extrahieren und in einer bestimmten Form darzustellen; Eigenschaften, Methoden und Mittel der Informationsinteraktion; Eigenschaften von Informationsressourcen, Methoden und Mittel zu ihrer Erstellung, Darstellung, Speicherung, Sammlung, Suche, Übertragung und Sicherung; Eigenschaften, Methoden und Mittel zur Konstruktion und Verwendung programmierbarer Maschinen und Mensch-Maschine-Umgebungen zur Lösung von Problemen.

Wissenschaftliche Produktion von Informatik

Die wissenschaftliche Produktion von Informatik dient als methodische Grundlage für die Konstruktion einer Mensch-Maschine-Umgebung zur Lösung von Problemen (Abb. 1) in verschiedenen Tätigkeitsfeldern.

Die Ergebnisse der Untersuchung von Entitäten (in der Wissenschaft üblicherweise als Objekte bezeichnet) werden durch ihre symbolischen und/oder physikalischen Modelle repräsentiert. Symbolische Modelle sind Beschreibungen von erworbenem Wissen [vgl. Symbolische Modellierung(s-modeling)], und physische sind Prototypen der untersuchten Objekte, die ihre Eigenschaften, ihr Verhalten usw. widerspiegeln. Das wissenschaftliche Ergebnis ist ein Modell eines Wissenssystems (oder eine Komponente eines zuvor definierten und veröffentlichten Modells), das beschreibt eine Reihe von Objekten, einschließlich des zu untersuchenden Objekts, und die Beziehungen zwischen ihnen . Die Beschreibung des Modells wird in Form einer Nachricht präsentiert, die zur Anerkennung und Interpretation durch die wissenschaftliche Gemeinschaft bestimmt ist. Der Wert des Ergebnisses hängt von der Vorhersagekraft, Reproduzierbarkeit und Anwendbarkeit des Modells sowie von den Eigenschaften der Nachricht ab, die seine Beschreibung enthält.

Beispiele für Ergebnisse, die bei der methodischen Unterstützung des Aufbaus einer Mensch-Maschine-Umgebung zur Lösung von Problemen eine herausragende Rolle gespielt haben, können sein: das von J. von Neumann erfundene Modell einer digitalen elektronischen Maschine mit in einem gemeinsamen Speicher abgelegten Programmanweisungen und Daten [ bekannt als das von-Neumann-Modell] und die von-Neumann-Architektur] ; erfunden vom Schöpfer des Internets (vgl. Das Internet) T. Berner Lee HTTP-Protokoll(eng. Hypertext Transfer Protocol – Hypertext Transfer Protocol), das ein Protokoll auf Anwendungsebene ist, das die Regeln für die Übertragung von Nachrichten in Hypermedia- (siehe Multimedia-) Systemen definiert, und einen einheitlichen Ressourcenbezeichner URI (eng. Uniform Resource Identifier), der über zum Standard für die Aufzeichnung der Adresse einer im Internet gehosteten Ressource geworden. Es ist schwer, heute (2017) ein Betätigungsfeld zu finden, in dem die wissenschaftlichen Produkte der Informatik nicht angewendet werden. Darauf aufbauend wurden E-Mail, das Web, Suchmaschinen, IP-Telefonie, das Internet der Dinge und andere Internetdienste geschaffen (siehe Internet); digitale Ton-, Foto- und Videoaufzeichnung; Computergestützte Entwurfssysteme (CAD); Computersimulatoren und Roboter (vgl. Computermodellierung), digitale Kommunikationssysteme, Navigationssysteme, 3D-Drucker usw.

Grundlegendes Konzept

Die Weiterentwicklung der Informatik wird begleitet von der Entwicklung ihres Begriffsapparates und der Verfeinerung des Forschungsgegenstandes. 2006 wurde am Institut für Informatikprobleme der Russischen Akademie der Wissenschaften (IPI RAS) ein neuer Forschungsbereich geschaffen - symbolische Modellierung beliebiger Objekte in einer Mensch-Maschine-Umgebung (abgekürzt- von symbolische Simulation oder S-Simulation). Eines der ersten wissenschaftlichen Projekte in diesem Bereich widmete sich der Methodik zur Konstruktion eines symbolischen Modells des Informatik-Wissenssystems in einer Mensch-Maschine-Umgebung. . In der 2009 erstellten Theorie der symbolischen Modellierung (S-Modellierung) wurde die nächste Version des symbolischen Modells des Kerns des Systems der Informatikkonzepte vorgeschlagen, die die folgenden Konzepte enthält.

Nachricht(engl. message) wird als eine endliche geordnete Menge von Symbolen (visuell, akustisch usw.; siehe Symbol in der Informatik) oder deren Code (siehe Code in der Informatik) betrachtet, der das Interaktionsprotokoll zwischen Quelle und Empfänger erfüllt. Die Existenz einer Nachricht setzt die Existenz einer Nachrichtenquelle, eines Empfängers, eines Trägers, eines Übertragungsmediums, eines Zustellmittels und eines Protokolls für die Interaktion zwischen Quelle und Empfänger voraus. In der Mensch-Maschine-Umgebung zur Problemlösung (S-Environment) bilden Menschen mit Hilfe programmierbarer Maschinen (S-Maschinen) Nachrichten, präsentieren sie in Abfragesprachen, programmieren etc.; verschiedene Umwandlungen durchführen (z. B. von analog zu digital und umgekehrt; von unkomprimiert zu komprimiert und umgekehrt; von einer Form der Dokumentendarstellung zu einer anderen); erkennen, Nachrichten verwenden, um neue Nachrichten zu konstruieren (Programme, Dokumente usw.); Interpretieren auf Modellen von Konzeptsystemen (die im Gedächtnis des Interpreten auch in Form von Nachrichten gespeichert sind); Nachrichten über software- und hardwareimplementierte Regelsysteme (Netzwerkprotokolle, siehe unten) austauschen. Computernetzwerk); Nachrichten speichern und sammeln (durch Erstellen elektronischer Bibliotheken, Enzyklopädien und anderer Informationsressourcen), die Probleme beim Suchen und Schützen von Nachrichten lösen.

Nachrichteninterpreter wird als Erbauer der Ausgabenachricht gemäß der Eingabe gemäß dem gegebenen System von Interpretationsregeln untersucht. Eine notwendige Voraussetzung für die Konstruktion eines Nachrichteninterpreters ist die Existenz von Modellen der Eingabe- und Ausgabesprachen sowie von Modellen von Konzeptsystemen, auf denen in den Eingabe- und Ausgabesprachen geschriebene Nachrichten interpretiert werden sollen.

Daten(eng. Daten) - eine Nachricht, die zur Lösung eines bestimmten Problems oder einer Reihe von Problemen erforderlich ist und in einer Form präsentiert wird, die für die Erkennung, Transformation und Interpretation durch den Löser (Programm oder Person) bestimmt ist. Eine Person nimmt Daten (Text, Bilder usw.) in symbolischer Form wahr, und ein Computerprogramm bzw Computergerät(Smartphone, Digitalkamera usw.) - im Code.

Information(engl. information) wird als Ergebnis der Interpretation der Botschaft nach dem Vorbild des Begriffssystems untersucht [vgl. Symbolische Modellierung(S-Simulation)]. Um Informationen aus einer Nachricht zu extrahieren, ist es notwendig, dass die empfangene Nachricht in einer Form präsentiert wird, die dafür ausgelegt ist, vom Empfänger der Nachricht erkannt und interpretiert zu werden; Konzeptsystemmodelle, die im Speicher des Interpreters gespeichert sind, darunter dasjenige, das zum Interpretieren der empfangenen Nachricht notwendig ist; Mechanismen für die Suche nach dem erforderlichen Modell, die Interpretation der Nachricht, die Präsentation des Interpretationsergebnisses in einer für den Empfänger bestimmten Form (Abb. 2).

Beispielsweise ist das Ergebnis des Interpretierens der Nachricht ma, präsentiert in Sprache a, empfangen durch den Übersetzer (Mensch oder Roboter) in Form einer Nachricht mb in Sprache b, die aus der Nachricht ma extrahierte Information.

Programmierbare Aufgabe(s-problem) wird als Menge betrachtet (Formul , Rulsys , Alg , Prog ), wobei Formel die Problemstellung ist; Rulsys - eine Reihe von Systemen verbindlicher und orientierender Regeln zur Lösung eines Problems, die an der Formel ausgerichtet sind; Alg ist die Vereinigung von Sätzen von Algorithmen, von denen jeder einem Element aus Rulsys entspricht; Prog ist die Vereinigung von Programmmengen, von denen jede einem der Elemente von Alg zugeordnet ist. Jedes Element aus Rulsys , Alg und Prog muss mit einer Anwendungsbeschreibung versehen werden. Beschreibungen der Verwendung von Rulsys-Elementen umfassen die Spezifikation der Art des Problemlösers (autonome S-Maschine, Netzwerkkooperation von S-Maschinen, Mensch-Maschine-Kooperation usw.), Infousw. Betriebsmodi des Problemlösers ( automatisch lokal, automatisch verteilt, interaktiv lokal usw.), Anforderungen an das erzielte Ergebnis usw. Beschreibungen der Anwendung von Programmen enthalten Daten zu Implementierungssprachen, Betriebssystemen usw.

Algorithmus– eine formalisierte Beschreibung einer endlichen Menge von Schritten zur Lösung des Problems, die einem der Elemente von Rulsys entsprechen und eine Eins-zu-Eins-Korrespondenz zwischen einer gegebenen Menge von Eingabedaten und der resultierenden Menge von Ausgabedaten ermöglichen.

Programm– ein Algorithmus, der in einer höheren Programmiersprache, einer maschinenorientierten Sprache und/oder in einem System von Maschinenanweisungen implementiert ist. Präsentiert in Form einer Nachricht, die das Verhalten eines S-Maschinen-Problemlösers mit bestimmten Eigenschaften definiert. Existiert in Symbol-, Code- und Signalinkarnationen, die durch Übersetzungsbeziehungen verbunden sind (siehe Compiler in der Informatik).

Symbol(englisches Symbol) - ein Ersatz für ein natürliches oder erfundenes Objekt, das dieses Objekt bezeichnet und ein Element eines bestimmten Systems zum Erstellen symbolischer Botschaften (Texte, Musiknoten usw.) ist, das dazu bestimmt ist, von einer Person oder einem Roboter wahrgenommen zu werden. Das russische Alphabet ist beispielsweise ein System von Textsymbolen; der Buchstabe A in diesem System ist ein Symbol, das den entsprechenden Ton aus dem System der Sprachaudiosymbole der russischen Sprache ersetzt; Der Buchstabe A entspricht einem taktilen Textsymbol (erfasst durch Berührung mit den Fingern) in einem Textnachrichtensystem für Blinde, das als Braille bekannt ist (siehe Abb. Blindenschrift). Der Satz von visuellen, akustischen und anderen Symbolen, die ausgewählt wurden, um Nachrichten eines bestimmten Typs aufzubauen, wird als ein Satz von elementaren konstruktiven Objekten betrachtet, von denen jedes mit einem Satz von Attributen und einem Satz von erlaubten Operationen ausgestattet ist. Die Bildung von Strukturen aus den Elementen dieser Menge wird durch das Regelwerk zum Aufbau symbolischer Modelle bestimmt [näheres dazu im Artikel Symbol in der Informatik (s-Symbol)].

Der Code(englischer Code) - ein Ersatz für ein Symbol oder eine symbolische Nachricht, die verwendet wird, um sie in Computern, Smartphones und anderen programmierbaren Maschinen darzustellen und um symbolische Nachrichten zu erstellen, zu speichern, zu übertragen und zu interpretieren [weitere Einzelheiten finden Sie im Artikel Code in der Informatik ( S-Code)].

Signal(engl. Signal) ist eine optische, akustische oder andere Wirkung, die von den menschlichen Sinnen oder maschinellen Sensoren wahrgenommen wird, oder die Darstellung des Codes in Form einer elektromagnetischen Strahlungsfrequenz, Zusammensetzungen von elektrischen Spannungswerten oder anderen, die wahrgenommen werden sollen die Maschinenhardware (z. B. die Zentraleinheit eines Computers, Mikroprozessor Autonavigation). Symbole, Codes und Signale sind durch Transformationsbeziehungen miteinander verbunden. Jedem Symbol und jeder symbolischen Konstruktion, die für die Wahrnehmung durch einen Menschen oder einen Roboter entworfen wurden, kann eine Eins-zu-eins-Korrespondenz mit Codes zugewiesen werden, die dazu bestimmt sind, sie mit Hilfe von Computersoftware und Computergeräten zu manipulieren.

Konzeptsystemmodell. Das S-Modell Cons eines Konzeptsystems wird als Paar betrachtet (ConsSet , ConsRel ), wobei ConsSet eine Menge von Konzepten ist; ConsRel ist eine Familie von Beziehungen, die auf ConsSet definiert sind. Definition eines Begriffssystems - eine Beschreibung seines Modells, begleitet von einer Angabe des Umfangs. Die Beschreibung wird in Form einer Nachricht präsentiert, die zur Interpretation durch den Empfänger, zur Präsentation, Speicherung, Verteilung, Akkumulation und Suche in der Mensch-Maschine-Umgebung der intellektuellen Aktivität bestimmt ist. Ein System von Begriffen, die als definitiv angesehen werden, sollte keine Begriffe enthalten, die keine Definitionen haben (und gleichzeitig nicht mit Begriffsaxiomen verwandt sind). Bestimmung des Umfangs der Anwendbarkeit des Modells - Beschreibung der Arten von Korrespondenten (an die sich die Definition richtet), das Ziel im Prozess der Erreichung, das die Definition sinnvoll macht (Klassen von Aufgaben, für deren Studium die Definition nützlich sein kann), die Phase, in der es ratsam ist, die Definition zu verwenden (Konzept, Lösungsmethodik usw.) d.).

Wissenssystemmodell. Das Konzept des „Know“ in der S-Modellierung [vgl. Symbolische Modellierung(s-simulation)] ist definiert als der Zustand des Nachrichtenempfängers, wenn die aus der Interpretation der Eingangsnachricht resultierende Ausgangsnachricht als bereits bekannt erkannt wird und keine Änderungen in den im Gedächtnis der Nachricht gespeicherten Modellen von Konzeptsystemen erfordert Empfänger. Der Begriff "Wissen" ist definiert als eine komplexe Fähigkeit, Informationen aus Nachrichten zu extrahieren, die die Bedingungen von Aufgaben einer bestimmten Klasse enthalten (dies können Aufgaben der Mustererkennung, Übersetzung von einer Sprache in eine andere oder andere Klassen von Aufgaben sein). Das S-Modell des Wissenssystems wird als Triade (Cons, Lang, Interp) betrachtet, wobei Cons das S-Modell des Konzeptsystems ist; Lang ist das S-Modell des Satzes von Nachrichtensprachen, die auf Cons interpretiert werden; Interp ist das S-Modell der Sammlung von Dolmetschern über Cons von Nachrichten, die in Sprachen von Lang verfasst wurden.

Die Interpretation der Nachricht zum Cons-Modell umfasst:

1) Erstellen einer Ausgangsnachricht (Extraktion von Informationen) gemäß einer gegebenen Eingangsnachricht (Nachrichten werden in Sprachen aus dem Satz Lang präsentiert);

2) Analyse der Ausgabenachricht (ob Änderungen im Cons-Modell erforderlich sind);

3) falls erforderlich, dann das Cons-Modell ändern; wenn nicht, ende.

Beispielsweise ist das Gehirnzentrum eines modernen computergestützten Konstruktionssystems (CAD) das Wissenssystem. Die Produktivität des Designs hängt davon ab, wie gut es gebaut ist.

Programmierbare Maschine(s-machine) ist eine Software- und Hardwarestruktur zum Lösen von Problemen. Supercomputer, Mainframes, PCs, Laptops, Smartphones, Navigationsgeräte, Digitalkameras und Videokameras sind alle S-Autos. Tastaturen, Mäuse, Trackballs, Touchpads und andere Eingabegeräte sind Bestandteile von S-Maschinen, die Zeichen in Codes umwandeln, die von Treibern (siehe Treiber in der Informatik) der entsprechenden Geräte akzeptiert werden. Monitore von Personalcomputern, Displays von Laptops, Navigatoren usw. wandeln von Videocontrollern generierte Codes in symbolische Kompositionen um, die für den menschlichen visuellen Kanal bestimmt sind.

(s-environment) - eine Vereinigung von Computernetzwerken und einzelnen programmierbaren Maschinen, die zur Lösung verschiedener Probleme verwendet werden. Mittel zur Informatisierung verschiedener Arten von Aktivitäten. Die S-Umgebung muss die Darstellung digitaler Codes symbolischer Modelle und die Manipulation solcher Codes mit Hilfe von S-Maschinen ermöglichen. Im Zentrum der modernen digitalen Kommunikationstechnologien, des computergestützten Designs usw. steht eine Idee, die in Bezug auf die Konsequenzen ihrer Umsetzung bemerkenswert ist – alle symbolische Vielfalt auf digitale Codes [und jeden von ihnen auf einen einzigen Code] zu reduzieren (sie haben immer noch einen binären Code)] und weisen programmierbaren Maschinen die Arbeit mit Codes an, kombiniert in einer Mensch-Maschine-Umgebung zur Problemlösung.

Informationsinteraktion im S-Medium(Abb. 3) wird als eine Menge von Schnittstellen wie „Mensch – Mensch“, „Mensch – Programm“, „Mensch – Hardware einer programmierbaren Maschine“, „Programm – Programm“, „Programm – Hardware“ untersucht (siehe Schnittstelle Port in der Informatik). Ein Mensch nimmt analoge Eingangssignale (Licht, Ton usw.) mit Hilfe von visuellen, auditiven und anderen Eingabegeräten der Biointelligenz (einem biologischen System, das die Funktion des Intellekts gewährleistet) wahr. Er wandelt die ihn interessierenden Signale in symbolische visuelle, akustische und andere Konstruktionen um, die in Denkprozessen verwendet werden. Die Ausgangssignale der Biointelligenz werden durch Gesten (z. B. bei der Eingabe über Tastatur und Maus), Sprache usw. realisiert. Die Ein- und Ausgabe der Programme sind die Eingabedaten und Ergebniscodes (siehe Abb. Der Code in der Informatik) und die Ein- und Ausgabe der Hardware sind Signale. Analoge Eingangssignale werden mit in digitale Signale umgewandelt Analog-Digital-Wandler(ADC) und der Ausgang digital zu analog mit Digital-Analog-Wandler(DAC).

In der modernen (2017) s-Umgebung werden natürliche Mittel der menschlichen Signalwahrnehmung, -verarbeitung und -speicherung durch erfundene ergänzt: digitale Foto- und Videokameras, Smartphones usw. Ein bekannter Teil der Infowird durch die sich schnell entwickelnde repräsentiert Internet-Dienste. Wird verwendet, um mit Menschen zu interagieren E-Mail(englische E-Mail), verschiedene Arten von Internetverbindungen [ Internettelefonie(IP-Telefonie); beispielsweise implementiert im Internetdienst Skype; Boten (engl. messenger - connected); B. der Internetdienst Telegram), soziale Netzwerke (engl. social networks) usw. Für die Interaktion von Dingen, die von Menschen genutzt werden (Beleuchtungssysteme, Temperaturhaltung usw.) untereinander und mit der äußeren Umgebung, werden Informationstechnologien der „ Internet der Dinge“ verwendet werden (vgl. Internet).

Grundlegende Aufgabenklassen

Basierend auf der Untersuchung von Eigenschaften und Mustern Symbolische Modellierung(s-simulation) werden die folgenden Klassen grundlegender Informatikprobleme definiert.

Darstellung beliebiger Objektmodelle, konzipiert für die menschliche Wahrnehmung und programmierbare Maschinen, ist mit der Erfindung von Nachrichtensprachen verbunden, die bestimmte Anforderungen erfüllen. Diese Klasse untersucht die Symbol- und Codesysteme, die in menschen- und maschinenorientierten Sprachen verwendet werden. Die erste umfasst Sprachen der Spezifikation, Programmierung, Abfragen, die zweite - Systeme von Maschinenanweisungen. Diese Klasse umfasst auch Datenpräsentationsaufgaben. Es umfasst die Aufgaben der Darstellung von Modellen von Konzeptsystemen, auf denen Botschaften interpretiert werden. Auf der obersten Ebene der Aufgabenhierarchie dieser Klasse steht die Darstellung von Modellen von Wissenssystemen.

Konvertieren von Typen und Darstellungsformen symbolischer Modelle ermöglicht es Ihnen, eine Korrespondenz zwischen Modellen herzustellen. Die Aufgaben der Umwandlung von Typen (zB Sprache in Text und umgekehrt) und Formen (zB analog nach digital und umgekehrt; unkomprimiert nach komprimiert und umgekehrt; *.doc nach *.pdf) sind eine notwendige Ergänzung der Aufgaben der Darstellung von Modellen.

Nachrichtenerkennung impliziert die Notwendigkeit, sie in einem dem Empfänger bekannten Format zu präsentieren. Wenn diese Bedingung erfüllt ist, werden zum Erkennen der Nachricht die Aufgaben des Abgleichs mit Modellmodellen oder des Abgleichs der Eigenschaften des erkannten Modells mit den Eigenschaften von Modellmodellen gelöst. Beispielsweise werden bei der Aufgabe zur biometrischen Identifizierung einer Person ihre biometrischen Daten (Eingabenachricht) mit einem biometrischen Muster aus der Datenbank des biometrischen Systems verglichen.

Modellbau Konzeptsysteme, Wissenssysteme, Nachrichteninterpreter auf Modellen von Konzeptsystemen; Aufgabenmodelle, Programmiertechniken, Interaktion in der S-Umgebung; Architekturmodelle von S-Maschinen, Computernetzwerken, serviceorientierten Architekturen; Nachrichtenmodelle und Mittel ihrer Konstruktion, Dokumente und Arbeitsabläufe. Auf der obersten Ebene der Hierarchie dieser Klasse befinden sich die Aufgaben der Konstruktion von S-Umgebungsmodellen und symbolischen Modellierungstechnologien.

Nachrichteninterpretation(Informationsextraktion) setzt die Existenz der empfangenen Nachricht, das Modell des Begriffssystems, nach dem sie interpretiert werden soll, und den Interpretationsmechanismus voraus. Das Lösen von Problemen in der Mensch-Maschine-Umgebung ist die Interpretation der Ausgangsdaten (Eingangsnachricht) nach dem Modell des im Algorithmus vorgestellten Begriffssystems. Das Ergebnis der Lösung ist die Ausgangsnachricht (aus der Eingangsnachricht extrahierte Informationen). Wenn der Interpreter ein ausführbares Programm ist, dann werden die Ausgangsdaten, das Programm und das Ergebnis der Problemlösung durch die entsprechenden Codes dargestellt (siehe Code in der Informatik). Für den Mikroprozessor der programmierbaren Maschine werden die zu interpretierenden Nachrichten und die Ergebnisse der Interpretation durch Signale dargestellt, die Maschinenbefehlen und Datencodes entsprechen. Beispielsweise wirkt beim Fotografieren mit einer Digitalkamera eine Nachricht (in Form eines Lichtsignals) auf eine lichtempfindliche Matrix ein, wird von dieser erkannt und dann in einen digitalen Bildcode umgewandelt, der von einem bildverbessernden Programm interpretiert wird Qualität. Das resultierende Ergebnis wird umgewandelt und (auf dem eingebauten Speicher oder der Speicherkarte der Kamera) als Grafikdatei gespeichert.

Nachrichtenaustausch: die Aufgaben der Konstruktion von Schnittstellen vom Typ „Mensch – Mensch“, „Mensch – Programm“, „Mensch – Hardware einer programmierbaren Maschine“, „Programm – Programm“, „Programm – Hardware“ (siehe Schnittstelle in der Informatik), „ Hardware - Hardware“ (siehe Port in der Informatik); Aufgaben des Messaging in einer Mensch-Maschine-Umgebung zur Lösung von Problemen (mit Eingabe von Absendern und Empfängern; Mittel zum Senden, Senden und Empfangen von Nachrichten; Messaging-Umgebungen). Systeme von Nachrichtenaustauschregeln (Netzwerkprotokolle) werden erfunden; Netzwerkarchitekturen; Dokumentenmanagementsysteme. Beispielsweise werden Nachrichten zwischen Prozessen ausgetauscht Betriebssysteme(OS), S-Maschinenprogramme in einem Computernetzwerk, E-Mail-Benutzer usw.

Nachrichten speichern, sammeln und suchen: Gedächtnis- und Speichergeräte, ihre Kontrollmechanismen werden untersucht und typisiert; Formen der Konservierung und Akkumulation; Medien, Methoden der Erhaltung, Akkumulation und Suche; Datenbanken und Softwarebibliotheken. Modelle des Suchgegenstands (nach Modell, nach Merkmalen, nach Beschreibung von Eigenschaften) und Suchmethoden werden untersucht.

Informationsschutz: Die Probleme der Prävention und Erkennung von Schwachstellen, Zugriffskontrolle, Schutz vor Eindringlingen, Malware, Abfangen von Nachrichten und unbefugter Nutzung werden untersucht.

Forschungsgebiete

Die wichtigsten wissenschaftlichen Ideen, die die Entwicklung der Informatik beeinflussen, sind in der methodischen Unterstützung für die Konstruktion von Werkzeugen zur Unterstützung der Prozesse der Kognition, der Informationsinteraktion und der automatisierten Lösung verschiedener Probleme enthalten. In der gegenwärtigen Phase (2017) der Entwicklung der Informatik sind die folgenden miteinander verbundenen Komplexe von Forschungsgebieten relevant.

Automatisierung von Berechnungen(Rechnen mit Hilfe programmierbarer Maschinen): Modelle, Architekturen und Befehlssysteme programmierbarer Maschinen werden untersucht; Algorithmisierung programmierbarer Aufgaben [Algorithmen und Datenstrukturen, verteilte Algorithmen (Distributed Algorithms), randomisierte Algorithmen (Randomized Algorithms) etc.]; Verteiltes Rechnen (Verteiltes Rechnen), Cloud Computing(Cloud Computing); Komplexität und Ressourcenintensität von Berechnungen.

Programmierung: Systeme von Textsymbolen und Codes werden untersucht; Programmiersprachen und Aufgabenspezifikationen; Übersetzer; Programmbibliotheken; Systemprogrammierung; Betriebssysteme; Instrumentelle Programmiersysteme; Datenbankmanagementsystem; Programmiertechnologien; Online-Dienste zur Lösung von Problemen usw.

Mensch-Maschine-Umgebung zur Problemlösung(S-Umgebung): Modelle, Methoden und Werkzeuge zum Aufbau einer S-Umgebung, Computernetzwerke, digitale Kommunikationsnetzwerke, das Internet werden untersucht.

Wahrnehmung und Präsentation von Botschaften, Interaktion in der S-Umgebung: Modelle, Methoden und Mittel der Wahrnehmung und Präsentation von visuellen, akustischen, taktilen und anderen Botschaften werden untersucht; Computersehen, Hören und andere künstliche Sensoren; Bildung von akustischen, visuellen, taktilen und anderen Nachrichten (einschließlich kombinierter Nachrichten), die für eine Person und einen Partnerroboter bestimmt sind; Erkennung von akustischen, visuellen und anderen Nachrichten (Sprache, Gesten usw.); Bildverarbeitung, Computergrafik, Visualisierung etc.; Nachrichtenaustausch (Nachrichtenmodelle, Methoden und Mittel ihres Empfangs und ihrer Übermittlung); Schnittstellen des Benutzers, Programme, Hardware, Programme mit Hardware; Online-Interaktionsdienste (Messenger, soziale Netzwerke usw.).

Informationsquellen und Systeme zur Lösung von Problemen im S-Umfeld: Modelle, Methoden und Mittel zum Erstellen, Darstellen, Speichern, Sammeln, Suchen, Übertragen und Schützen von Informationsressourcen werden untersucht; Elektronische Dokumentenverwaltung; elektronische Bibliotheken und andere Informationssysteme; Web (vgl Das Internet).

Informationssicherheit und Kryptografie: Methoden zur Prävention und Erkennung von Schwachstellen werden untersucht; Zugangskontrolle; Schutz von Informationssystemen vor Eindringen, Malware, Abfangen von Nachrichten; unbefugte Nutzung von Informationsressourcen, Software und Hardware.

Künstliche Intelligenz: Modelle, Methoden und Werkzeuge zum Bau intelligenter Roboter, die als menschliche Partner (zur Lösung von Sicherheitsproblemen, Situationskontrolle usw.) eingesetzt werden, werden untersucht; Experten-Entscheidungsmethoden.

Symbolische Modellierung: Systeme von visuellen, akustischen, taktilen und anderen Symbolen werden untersucht, die als konstruktive Objekte für den Bau von Modellen beliebiger Entitäten betrachtet werden, die für eine Person entworfen wurden (Konzeptsysteme und Wissenssysteme, Umgebungsobjekte und von Menschen erfundene Objekte); Codesysteme, die mit Symbolsystemen in Übereinstimmung gebracht werden und zur Konstruktion von Codeäquivalenten symbolischer Modelle bestimmt sind, die für die Manipulation mit Hilfe von Programmen bestimmt sind; Sprachen zur Beschreibung symbolischer Modelle; Typisierung symbolischer Modelle und ihrer Code-Äquivalente; Methoden zur Konstruktion symbolischer Modelle von Konzeptsystemen und Wissenssystemen (einschließlich Wissenssystemen über programmierbare Aufgaben) [weitere Einzelheiten finden Sie im Artikel Symbolische Modellierung(S-Simulation)].

Die Entstehung der Informatik

Symbolische Modellierung von Untersuchungsobjekten dient seit langem als wichtigstes Instrument zur Präsentation von erworbenem Wissen. Die Erfindung von Symbolen (gestisch, graphisch usw.) und die daraus aufgebauten symbolischen Botschaftsmodelle, die Repräsentation und Akkumulation solcher Modelle in der äußeren Umgebung sind zu Schlüsselmitteln für die Bildung und Entwicklung intellektueller Fähigkeiten geworden. Die dominierende Rolle symbolischer Modelle in der intellektuellen Aktivität wird nicht nur durch ihre Kompaktheit und Ausdruckskraft bestimmt, sondern auch durch die Tatsache, dass es keine Beschränkungen hinsichtlich der Art der Medien gibt, in denen sie gespeichert werden. Die Medien können ein menschliches Gedächtnis, ein Blatt Papier, eine digitale Kameramatrix, ein digitaler Sprachaufzeichnungsspeicher oder etwas anderes sein. Die Kosten für das Bauen, Kopieren, Übertragen, Sichern und Sammeln von symbolischen Modellen sind unvergleichlich geringer als ähnliche Kosten, die mit nicht symbolischen Modellen (z. B. Modellen von Schiffen, Gebäuden usw.) verbunden sind. Ohne symbolische Modellierungswerkzeuge ist die Entwicklung von Wissenschaft, Technik und anderen Aktivitäten schwer vorstellbar.